Jika umumnya proses editing pada video hanya bisa dilakukan oleh para profesional di ranah perfilman dan teknologi media, maka kini dengan perkembangan teknologi yang pesat siapa saja bisa melakukan tindakan tersebut. Maka kemudian, muncul lah teknologi deepfake.

Deepfake merupakan sebuah teknologi yang berbasis AI (Artifical Intelligence) dan bekerja dengan melakukan melalui cabang dari AI yaitu deep learning. Maka dari itu, istilah deepfake ini merupakan gabungan dari 'deep learning' dan 'fake'. Deep learning sendiri merupakan cabang AI dimana teknologi tersebut 'melihat' sesuatu beberapa kali sebelum menjadi cepat dan dapat memahaminya.

Bantuan dari teknologi AI terutama dalam hal 'deep learning' ini, membuat deepfake bisa menerapkan teknologi untuk mengedit atau memanipulasi visual manusia dalam foto atau video dengan sesuatu yang tidak pernah mereka lakukan atau katakan.

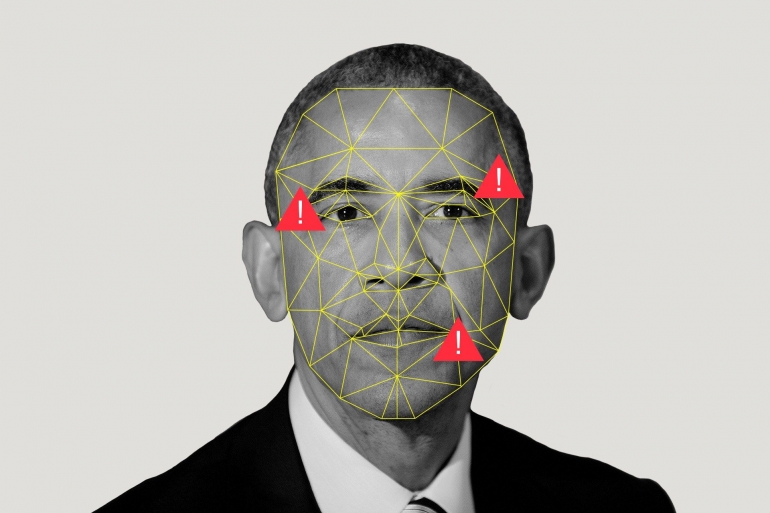

Adanya deepfake yang memungkinkan seseorang untuk memanipulasi sebuah video dengan wajah yang diinginkan hingga terlihat nyata, tentunya menjadi ancaman untuk hoaks. Manipulasi yang dilakukan terhadap wajah seseorang di dalam video dilakukan dengan sangat detil, sehingga akan menjadi sulit untuk melakukan deteksi kebenaran dari video yang telah dimanipulasi.

Bahkan pada perkembangannya, deepfake tidak hanya dilakukan melalui tempelan wajah saja; tetapi telah dikembangkan teknologi AI dimana fitur deep learning yang disebutkan sebelumnya bisa dilakukan dengan mudah. Hal ini ditunjukkan dengan mengedit sebuah pembicaraan semudah mengedit transkrip. Teknologi ini masih berupa pengembangan oleh peneliti dari Adobe Research dan beberapa universitas di Amerika Serikat; namun kedepannya, bisa saja digunakan secara luas.

Korban dari deepfake ini bisa dari berbagai kalangan, baik selebriti maupun tokoh politik. Salah satu yang menjadi korban adalah Scarlett Johansson. Aktris ini menjadi korban deepfake dimana wajahnya digunakan untuk video porno; sehingga seolah-olah dialah yang menjadi pemerannya.

Sasaran lain dari deepfake adalah mantan presiden Amerika Serikat Barack Obama. Beliau dibuat seolah-olah mengatakan kata-kata kasar pada presiden Donald Trump yang kini tengah berkuasa. Hal ini menunjukkan jika deepfake bisa jadi sangat merugikan bagi berbagai kalangan yang videonya dimanipulasi.

Pengaruh yang diberikan deepfake menjadi besar, dan bisa menimbulkan ancaman yang cukup besar terutama di zaman yang serba cepat sekarang ini. Hoaks bisa saja tersebar lebih cepat dengan video deepfake yang terlihat seolah-olah nyata. Pada beberapa konteks, teknologi deepfake memang bisa untuk konten komedi. Seperti deepfake Jennifer Lawrence yang wajahnya diganti dengan aktor Steve Buscemi.

Pada konteks jurnalisme, keberadaan deepfake jelas bisa mengancam reputasi jurnalis. Hal ini dikarenakan konten video deepfake bisa mengaburkan batas antara fakta dan palsu. Beberapa jurnalisme 'nakal' bisa saja mengaburkan fakta pada laporan dengan melakukan deepfaking pada video laporan tertentu.

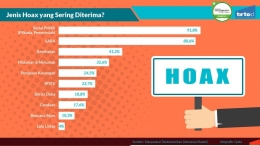

Pemalsuan fakta tersebut memungkinkan terjadinya misinformasi yang akhirnya berakhir pada penyebaran berita palsu atau hoaks. Deepfake bisa menambahkan populasi fakta atau berita palsu yang tersebar melalui internet, dan dalam data sendiri sudah dalam tingkat yang cukup tinggi.

Data-data yang ditampilkan diatas menunjukkan jika keberadaan deepfake bisa mengancam penyebaran informasi melalui media. Penciptaan hoaks yang sebelumnya masih bisa dideteksi dengan situs seperti cekfakta.com atau lembaga mafindo menjadi semakin sulit. Hal ini karena batas fakta dan kebohongan menjadi kabur sehingga kebohongan terlihat sangat nyata.

Mendeteksi deepfake menjadi kesulitan tersendiri dikarenakan setiap kali ditemukan cara untuk mendeteksi sebuah video deepfake, maka 'kelemahan' tersebut akan digunakan oleh para pengembang teknologi deepfake seperti DeepFaceLab untuk lebih mengembangkan teknologi mereka agar memberikan kesan lebih 'nyata'. Hal ini seperti yang dinyatakan oleh Ben Zhao.

Jika pada DeepFaceLab pembuatan deepfake masih memerlukan bimbingan dan diaplikasikan lewat komputer, maka kini deepfake hadir pada aplikasi di smartphone bernama ZAOapp yang merupakan buatan Cina. Adanya aplikasi ini memudahkan seseorang untuk menempelkan wajah mereka pada video seperti adegan dalam film atau video jenis lainnya.

Penggunaan yang mudah karena aplikasi ini bisa diperoleh melalui toko aplikasi di smartphone, tentunya membuat aplikasi ini menjadi populer; cukup dengan satu foto yang diunggah dan beberapa gerakan wajah; maka deepfake bisa dibuat segera. Simak pemakaian aplikasi ZAO pada video berikut :

Maka dengan kemudahan yang ditawarkan tersebut, menjadi mengkhawatirkan terkait dengan efek dari deepfake yang bisa membelokkan fakta yang benar. Pembelokkan fakta yang benar bisa memunculkan misinformasi yang mengkhawatirkan dikalangan masyarakat, dan menimbulkan pengaruh pada berbagai kejadian besar seperti pemilu. Dimana ada potensi disinformasi yang besar dan mengancam keamanan negara, seperti Amerika Serikat yang akan melaksanakan pemilu pada 2020.

Tentunya pada konteks jurnalisme, menjadi ancaman jika deepfake mengambil alih dalam hal penyebaran informasi. Bisa jadi, konten deepfake yang lebih banyak dianggap sesuatu yang benar dan bisa mencederai reputasi jurnalisme.

Seperti yang sudah sering kita lihat, jika jurnalisme sekarang ini baik online maupun konvensional dalam televisi banyak mengandalkan audiovisual untuk menampilkan informasi yang akan disampaikan. Keberadaan deepfake bisa membelokkan fakta-fakta audiovisual yang disampaikan; sehingga jurnalis atau pelapor yang terlibat bisa menyampaikan sesuatu yang tidak dikatakan dalam video tersebut.

Bagaimana melawan deepfake?

"Pada dasarnya, melawan keberadaan deepfake dengan ancaman yang dibawanya sama seperti melawan hoaks."

Dari pengguna, tentunya diperlukan ketelitian mengenai sumber video tersebut berasal dan tentunya dilakukan pengecekan dengan pihak ketiga.

Melawan keberadaan deepfake tidak hanya dilakukan oleh pengguna dan penerima informasi saja, tetapi juga dilakukan oleh para developer berbagai situs yang aktif digunakan oleh para pengguna internet masa kini.

Google misalnya, melawan deepfake dengan membagikan basis data video deepfake sebanyak 3000 video deepfake. Pembagian data pencarian sebesar ini diharapkan Google dapat digunakan oleh para peneliti untuk mencari celah melawan ancaman hoaks yang dibawa oleh teknologi video deepfake.

Selain Google, Facebook juga melakukan tindakan untuk melawan video deepfake ini. Facebook menyediakan basis data video deepfake tersendiri yang dibuat sendiri oleh Facebook; berisi aktor-aktor yang tahu jika mereka berpatisipasi dalam video yang dimanipulasi isinya. Proyek ini sebagai bagian dari sponsor terhadap kompetisi bernama Deepfake Detection Challenge, yang harapannya akan menarik partisipasi pada peneliti AI (Artificial Intelligence).

Google dan Facebook sebagai situs terbesar yang banyak diakses oleh para pengguna internet melakukan penanggulangan terhadap deepfake dan efek negatif yang dimiliki dengan memproduksi hal yang sama; harapan dari kedua proyek ini sama, yaitu agar para peneliti AI bisa tertarik membantu menemukan celah mendeteksi video deepfake.

Seperti yang telah dijelaskan sebelumnya, video deepfake memiliki potensi penyebaran hoaks yang sangat tinggi; didukung dengan teknologi yang bisa mengaburkan batas antara palsu dan fakta. Maka dari itu, pengguna harus tetap berhati-hati dalam berselancar di internet dan tetap kritis dalam melihat informasi tertentu yang didapat.